бюджет 9 Съвети за оптимизация на сайта kraulingovogo

Какво свързвате фразата "Оптимизация за търсачки"? Мнозина веднага идва на ум списък с класиране фактори, като точните тагове, подходящи думи, ясно карта на сайта и качеството на съдържанието. Но има и друг важен аспект - kraulingovy бюджет.

Много SEO-експерти не обръщат внимание на този фактор, не е съвсем разбирането си точка. Въпреки kraulingovy бюджет може и трябва да бъде оптимизирана. Това ще бъде обсъдено в статията.

Какво е мястото на kraulingovy бюджет?

Уеб услуги и търсачки използват специални роботизирани паяци, които обхождат мрежата и да ги добавите към индекса. Влечуго определят също връзки към страници и да ги местят, за да сканирате другите страници.

Сред търсенето роботи двигателя се появяват Googlebot, Bingbot и др. Много SEO инструменти също използват паяци за събиране на информация.

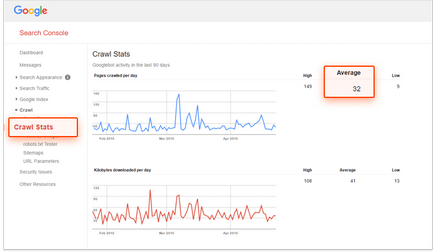

Терминът "kraulingovy бюджет" се отнася до броя на страниците, че роботът може да бъде прескочена за определен период от време. Ако Googlebot сканира 32 страници на ден, месец kraulingovy бюджет ще бъде 960 страници.

Определяне на приблизителното сайта на бюджета kraulingovy, можете да използвате услуги като Google Search Console и Bing Инструменти за уеб администратори. За да направите това, отворете доклада, "Статистически данни за обхождането" и да видим колко, средно сканирани страници на ден.

Оптимизация kraulingovogo бюджет = SEO?

Да, и не. Въпреки че и двата вида оптимизация са предназначени да направят страници по-видими за търсачките, те са различни по характер.

SEO поставя по-голям акцент върху оптимизацията на потребителски опит и индексиране сайт фокусиран върху търсачките. По думите на основателя на KISSmetrics Neil Patel:

«SEO е насочена към оптимизиране на процесите за потребителски заявки. Оптимизиран за Googlebot - за това как Google търсене робот печалби достъпа до сайта на ".

Как да се оптимизира бюджета си kraulingovy

Ако не искате страницата да се появяват в резултатите от търсенето, трябва да се откаже достъп до него в .htaccess и robots.txt. Въпреки това, според Google. един Забрана директиви в robots.txt не е достатъчно:

"Директива Disallow не гарантира липсата на страницата с резултати от търсенето. Google все още може да го сканира, като се отчита съответната информация на трети лица, като например входящи връзки. Ако искате да бъде строго забранено да я индексира, използвайте роботите мета тагове на стойност Noindex или HTTP-заглавни X-роботи-Tag. В този случай, не блокира достъпа до страницата в robots.txt, защото роботите на Google, за да го сканират, за да намерите маркера и изпълнение на директивата. "

Мета маркера на роботите с Noindex атрибут. Поставете го в секцията

страница:X-роботи-маркер. Заглавие X-роботи-Tag могат да бъдат елемент на HTTP-позиция за даден URL адрес. Noindex директива, които могат да бъдат използвани в мета роботи, и е приложим и за X-роботи-Tag:

Сега Google могат да се справят повечето видове мултимедийни файлове, но не всички търсачки тя може. Поради това тези файлове трябва да се използват с повишено внимание. То може да бъде разумен и не им се даде до тези страници, които искате да видите в резултатите от търсенето.

Списък на всички типове файлове, които Google може да индексира могат да бъдат намерени тук.

Въпросът дали счупените връзките в класацията, говорител на Google Джон Myuller влияние е казал. "Не, това е важно преди всичко за потребителите."

Ако думите му - все пак, това е една от основните разлики между SEO и оптимизация за търсачки. Счупени връзки не играят съществена роля в класацията, дори ако те са трудно да се Googlebot индексиране и класиране на сайта.

Въпреки това, алгоритмите на Google се подобряват всяка година, и всичко, което се отразява на потребителския интерфейс, в крайна сметка може да повлияе на резултатите от търсенето.

Търсене роботи се справят с URL динамичен, което води до една и съща страница, тъй като различните страници. Това означава, че по този начин могат да бъдат изразходвани kraulingovy бюджет. Можете да контролирате параметрите на URL адреса в конзолата за Google Търсене. За да направите това, отидете на "Настройки URL» раздел. Тук можете да ни кажете, как да се справи с URL, които съдържат определен параметър. По този начин, ще бъде възможно да се елиминират дублиране на съдържанието на сайта.

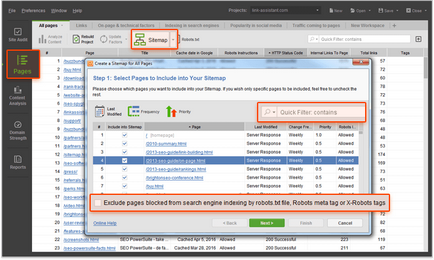

XML Карта на сайта файл и помага на потребителите и търсачките, организиране на съдържание и което го прави по-лесно да се търси. Дръжте карта на сайта актуален и да го почистите от всичко, което може да увреди на използваемостта на ресурса: страниците, които връщат грешка 4xx, ненужни пренасочвания, неканоничен URL, и блокирани от индексиране.

За да донесе карта на сайта, за да можете да използвате инструмент Сайт одитор на. С XML Sitemap Generator можете да създадете нова карта на сайта, която ще се лишите от заключените индексираните страници. В одит на сайта ще бъде лесно да се намери, връщайки 4xx страници за грешка 301 и 302 пренасочвания и неканонични страници.

RSS-емисия са отдавна се смята за добър начин за увеличаване на участието на потребителите. Те също са сред средствата, които са най-често посещавани от Googlebot. Когато сайтът се обновява, предаде тази информация към горелката поток от Google, така че е добре индексиран.

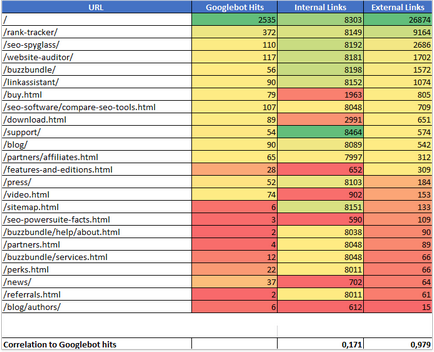

Един скорошен експеримент Йохан Kutarnyuka показа, че входящи връзки са взаимно свързани с броя на посещенията на сайта Ви от търсачките.

По време на експеримента Kutarnyuk идентифицирани всички вътрешни и външни връзки, сочещи към всяка от страниците на 11 различни места. След това той анализира статистическите данни за всяка страница, както и в сравнение на резултатите. По-долу - данните, получени от един от сайтовете:

силна корелация е намерено в експеримента (0,978) между броя на посещенията на робот за търсене на сайта и броя на външни връзки.

Kutarnyuka експеримент показа, че на вътрешния запитване не оказват съществено влияние върху скоростта на сканиране. Все пак, това не означава, че те трябва да бъдат игнорирани. Обмислена структура на сайта позволява на роботите на търсачките за намиране на съдържание, без да харчите бюджета kraulingovy губи.

Логически и добре обмислена структура на вътрешни връзки също така да подобри потребителския опит - особено ако посетителят може да получи до всяка точка на обекта в три кликвания. По-лесен достъп до съдържанието гарантира, че потребителите прекарват на сайта по-дълго. В резултат на това, той може да подобри класирането.

заключение

Оптимизация бюджет kraulingovogo сайт - е важна част от SEO-експерти, и то трябва да се направи. Когато се улесни Google индексиране на ресурса, роботи паяци често тя се посещава и актуализацията ще се появи в резултатите от търсенето. Можете също така подобрява опита на взаимодействие с потребителите на сайта, което в крайна сметка води до увеличаване на позициите си в търсенето.